一、DeepSeek R1介绍

DeepSeekR1是一款开源 AI 模型,其性能可与 OpenAI 的 GPT-4 和 Claude 3.5 Sonnet 等顶级模型媲美,尤其在数学、编程和推理等任务上表现出色。最重要的是,它是免费、私密的,可以在本地硬件上离线运行。

DeepSeek R1 提供多个参数规模的版本,从轻量级的 1.5b 参数模型到高性能的 671b 版本。它基于 Qwen 7B 架构的精简优化版本,既保持强大性能,又具备更高的计算效率。

其主要亮点包括以下几点:

a、完全开源,可自由使用。

b、支持本地运行,无需依赖云服务器。

c、数据完全可控,确保隐私安全。

二、为什么选择本地部署?

本地运行 AI 模型有以下优势:

隐私保障:所有数据均存储在本地,避免敏感信息泄露。

零额外成本:DeepSeek R1 免费运行,无需订阅或额外费用。

完全控制:可以进行微调和本地优化,无需外部依赖。

三、硬件要求

部署 DeepSeek R1 需要一定的硬件资源,以下是不同模型对计算机,GPU的基本要求, 仅供参考:(如果本机Window系统部署去体验,建议选择1.5b 版本,比较快速。)

四、安装步骤

首先准备一台有GPU的服务器,安装Ubuntu 22 系统(推荐安装此系统)

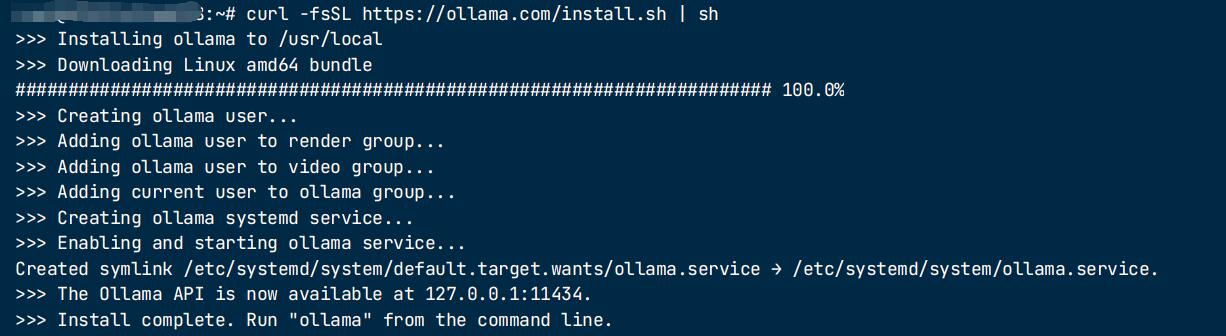

步骤 1:安装 Ollama

Ollama 是一款本地 AI 运行工具,可帮助用户轻松运行 DeepSeek R1。

下载地址:https://ollama.com/download/linux

直接执行 curl -fsSL https://ollama.com/install.sh | sh

安装完成后,Ollama 提供了在终端直接运行 AI 模型的功能。

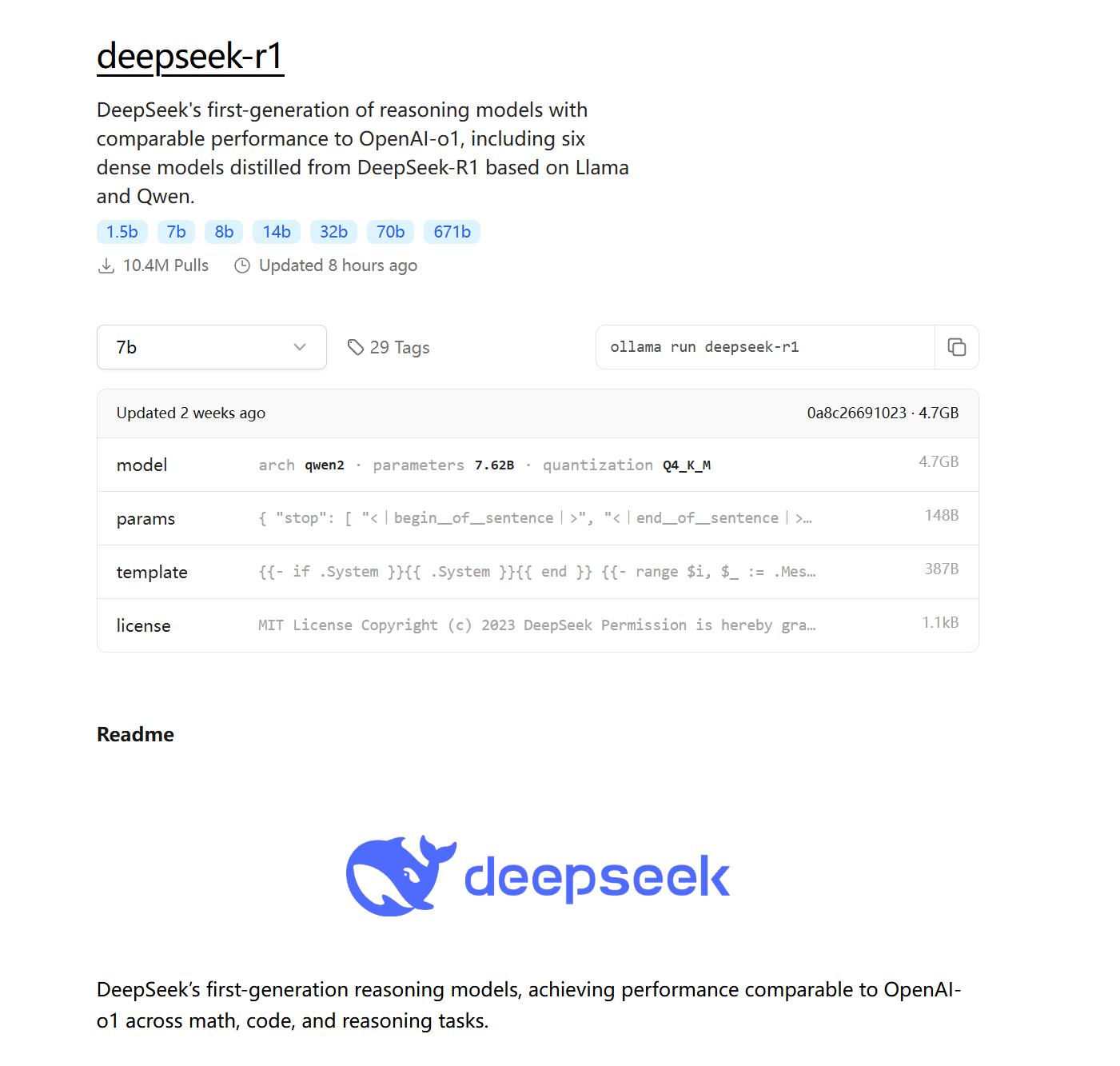

步骤 2:下载 DeepSeek R1 模型

下载地址:https://ollama.com/library/deepseek-r1

在终端中运行以下命令,根据你的硬件选择合适的模型:

# 下载 1.5b 版本(适用于 CPU 及低配 GPU)

ollama run deepseek-r1:1.5b

# 下载 7b 版本

ollama run deepseek-r1:7b

# 下载 8b 版本

ollama run deepseek-r1:8b

# 下载 14b 版本

ollama run deepseek-r1:14b

# 下载 32b 版本

ollama run deepseek-r1:32b

# 下载 70b 版本

ollama run deepseek-r1:70b

# 下载 671b 版本(最高性能)

ollama run deepseek-r1:671b

安装完成如下:

模型下载速度取决于网络状况,可能需要几分钟到几十分钟不等。

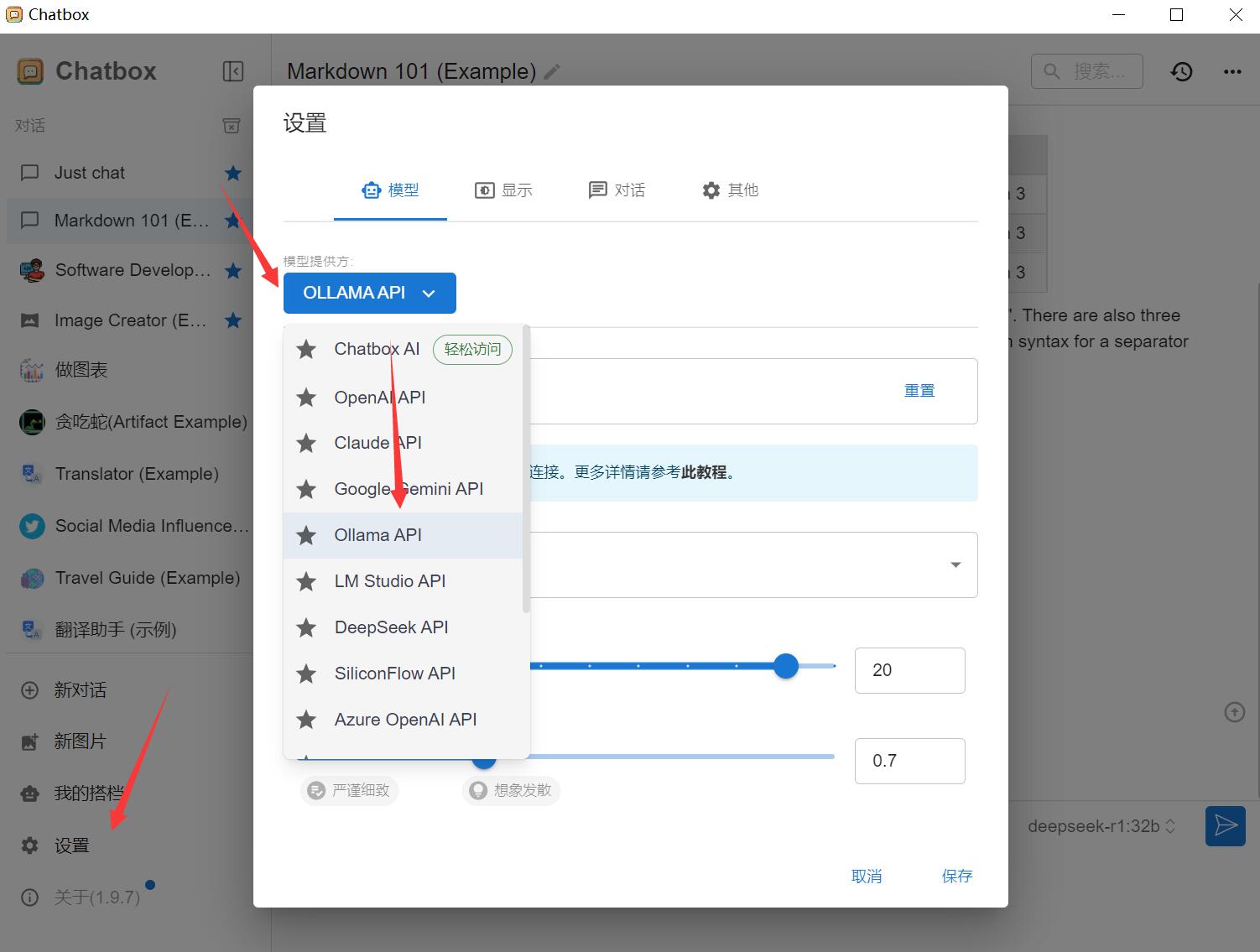

步骤 3:安装 Chatbox(可选)

为了获得更好的交互体验,可以安装 Chatbox 作为 GUI 界面。

下载地址:https://chatboxai.app/zh#download

下载后直接双击后即可。

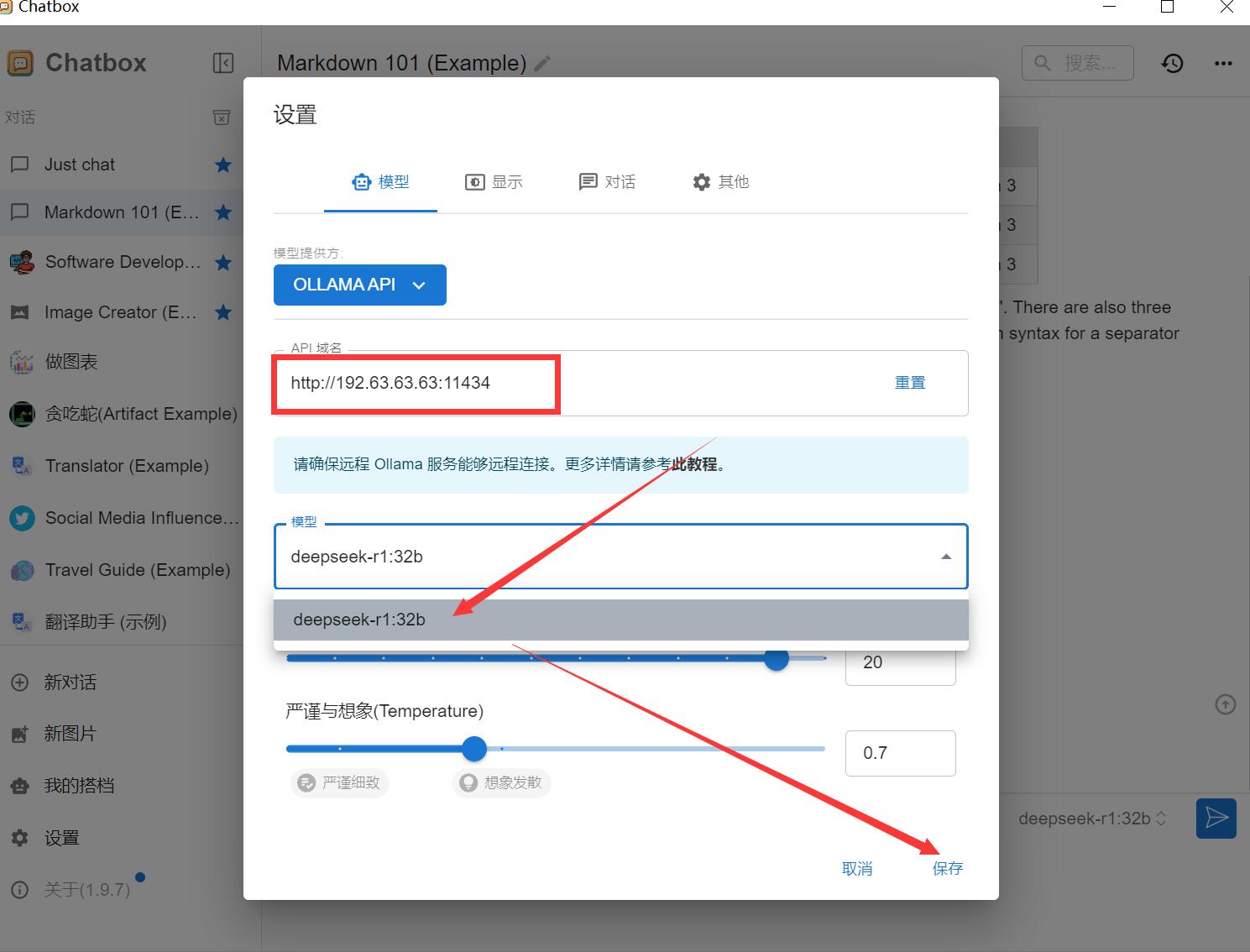

安装完成后,进行以下配置:

在“配置 API 模型”选项中选择 Ollama API。

假如您的服务器IP是:192.63.63.63

那么这里设置 API 主机为:http://192.63.63.63:11434

选择 DeepSeek R1 作为默认模型。

保存设置。

请注意:默认安装好的 Ollama 服务是不对外开放的,如何配置远程 Ollama 服务?

默认情况下,Ollama 服务仅在本地运行,不对外提供服务。要使 Ollama 服务能够对外提供服务,你需要设置以下两个环境变量:

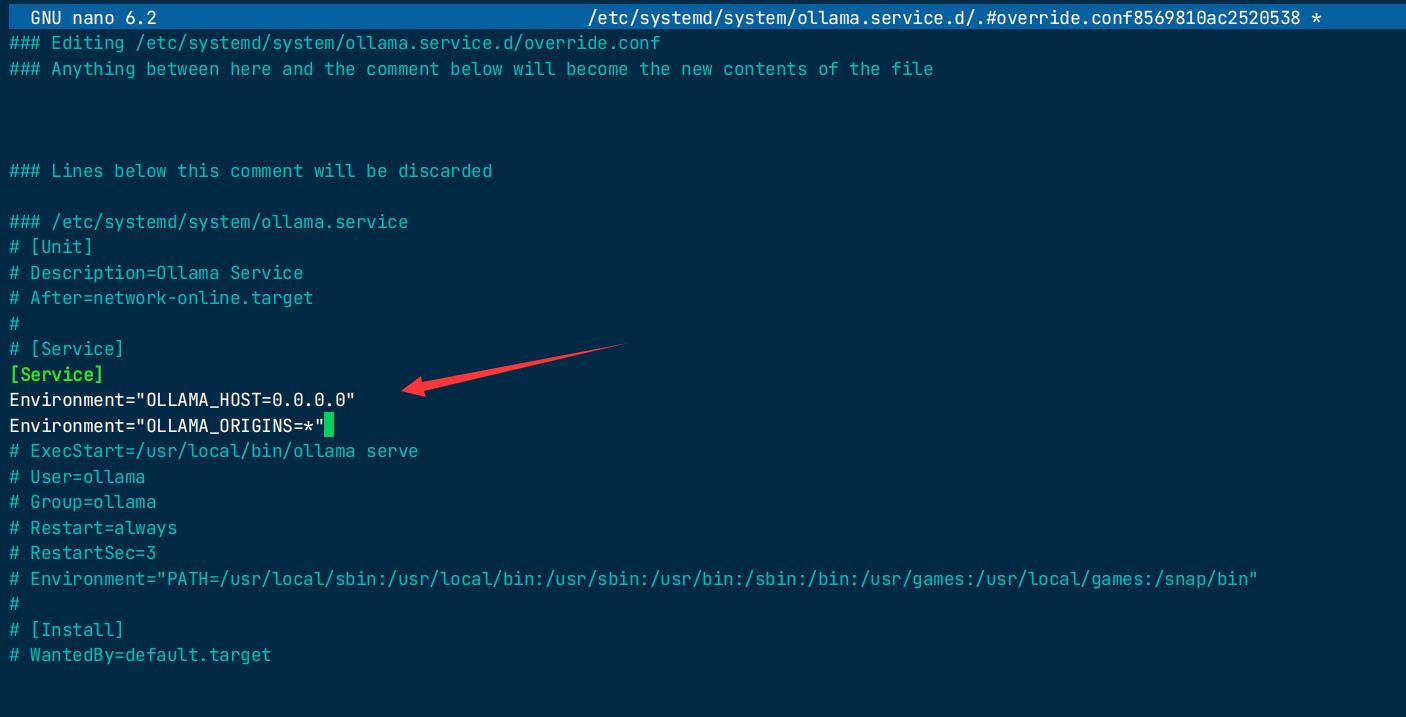

如果 Ollama 作为 systemd 服务运行,应使用 systemctl 设置环境变量:

调用 systemctl edit ollama.service 编辑 systemd 服务配置。这将打开一个编辑器。

在 [Service] 部分下为每个环境变量添加一行 Environment:

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_ORIGINS=*"

按Ctrl+X退出,再按Y保存并退出

重新加载 systemd 并重启 Ollama:

systemctl daemon-reload

systemctl restart ollama

五、功能演示

此时打开Chatbox ,选择对接好的DeepSeek ,即可正常对话。

推荐文章

推荐文章